雑文発散

2002-11-13 お外で仕事?な水曜日

▼ 隠密行動

いま、とあるイベント会場に来ています。『フリーライター』という肩書きの名刺を持って(笑)

▼ 隠密終了

結論だけ言うと「厚顔無恥」。

▼ 会話

頭が良い人と話すのは楽しい。物事をいろいろな角度から見ているので、こちらが気付かなかったことを教えてくれるから。僕も割と分析派(?)なのだけれど、この人にはかなわない。

2003-11-13

▼ [映] ユニバーサル、DVD「ナイトライダー」、「Aチーム」の音声仕様を変更 (AV Watch)

日本語吹き替え音声の収録をやめて、英語音声+字幕に変更らしい。わかってないなー。こういう懐かしの海外ドラマは日本語吹き替え版で観たいのに。

▼ [雑] 火事

近所のマンションで火事があったらしく、帰る途中で消防車などが多数停車していた。既に鎮火していたようだが、山手通りを挟んで向かい側の歩道を通ったのにコゲ臭かったので、それなりの規模だったのかもしれない。テレビ朝日のカメラの周囲で、ケータイカメラで撮影していた人たちが多数いたのが印象に残った。

▼ [本] 陰摩羅鬼の瑕 / 京極夏彦

ようやく読了。読んでる途中で「もしかして!」と思った通りの結末になってしまった。かなり長い期間かけて読んでいたので、あれこれ考える時間があったから見えてしまったのかもしれない。あと、榎木津にはもう少し活躍してほしかったなぁ。

2004-11-13

▼ [雑] マッサージ

今週はずっと肩こりがひどくて、背中も張っていて、昨日あたりは何もしてなくても辛くて涙目になってた。ということで、マッサージへ。

最初にローラーベッドに乗ったら、その感触がいつもと明らかに違う。ローラーが背中に触れるたびに「ぐぇぇ」と心の中で声が出るほど。その後で、珍しくメガネをしていた女先生に踏まれても、最初はなかなか効かなかった。でも、さすがに終わったときには体が軽くなってた。念のため帰りがけに湿布を貰ってきた。

しかし、歯医者といい、マッサージといい、なんか治療の話ばっかりだな。。。

▼ [物] ペン立て

iMac G5 を入手してから、努めて机の上のスペースを確保しようとしているのだが、最近なくて不便だなと思っていたのが「ペン立て」。マッサージを終えて体が軽くなったのを良い事に、ちょっと探してみる事に。

最初に行ったのがガーデンプレイスの etranger di costarica 。ここの製品デザインが好きなので、ペン立てがあれば買ってやる勢いで行ったのだけれど、残念ながらコレと行ったモノが無かった。この時点で、欲しいイメージがだいたい決まった。金属メッシュのペン立てがいいなぁ、と。

次に向かったのは、アトレ恵比寿の無印良品。たしか金属メッシュの製品群があったよなぁと思っていたのだけど無い。無印って、金属メッシュ系の製品ってなかったんだっけ?

同じフロアにソニプラもあったので見てみたけど、なんかソレっぽいモノが全然なくて、早々に退散。

今日はもうダメかぁと傷心しつつ、本屋で新刊本でもブラウズするかぁと上階に上ったら、有隣堂には文房具売り場が併設されていたのに気がついた。でも、無いだろうなぁと期待せずにウロウロしたところ、、、あったよ!、ほぼイメージ通りのモノが。しかも、小物入れもあったので同時に購入。

▼ [物] アイボントローリ目薬

最近ウワサ、、というか、こないだまどっこと話をしていて話題に出ただけなのだが、「とろっとしたさしごこち」ってな目薬を買ってみた。

ゼリー状なのかなと思っていたけど、そんなことはなく、ちょっと「とろっと」した液体。シャカシャカと振ってみると、空気の泡がゆっくり上がって行くので、普通の目薬より粘度が高いのが分かる。

実際に注してみると、、、んー、よくわからん。まぁ、せっかく買ったので使い続けてみるけど。

2005-11-13

▼ [食] 野方ホープ軒

さっぱりしたラーメンを食いたいなと思って、権之助坂を上って物色。前から名前が気になっていた野方ホープ軒に入ってみた。何を選んだものかと悩んだのだが、結局角煮ラーメンと半チャーハンを。

どうもオレの中で「野方ホープ軒=さっぱり」という図式が成り立っていたのだが、これって単なる思い込みで、思いっきりこってり系だった。角煮は旨かったけど、欲していたものではなかったので、今日の評価は低し。半チャーハンもいまひとつ。

▼ [物] ワンデー アキュビュー モイスト

目薬にも配合されている「うるおい成分」を配合した1日使い捨てのコンタクトレンズだそうだ。いつの間にかこんなん出てたんだな。

今は普通のワンデーアキュビューを使っているんだけど、次からコレにしてみようかな。ちょっと割高になるけど。

▼ [映] 機動戦士ガンダムF91

TSUTAYAが半額キャンペーンをやっていたので、まだ観たことがなかったガンダムF91を借りてきた。で、観てみたのだが、、、なに、このつまらなさは? 監督を始め、スタッフが凄そうだったので期待していたんだけどなぁ。

ガンダム病の夫をもつ妻の日記のダンナさんがどういう評価をしているのか聞いてみたい。

2006-11-13

▼ [GTD] 週次レビュー2回目

ホントなら土曜日にやる予定にしていたんだけど、いろいろあってようやく今日レビューを行った。

やっぱり「いつかやる」リストの中に完了したタスクがあったりして、どうも分類がいまひとつっぽい、あるいは、リストを無視してタスクをこなしている部分があるのかも。

だんだん分かってきたのは「プロジェクト」にいれるべきタスク。「次にとるべきアクション」にはできるだけ具体的な内容を入れるようにしているので、具体的に落とし込むのが(その場では)面倒なタスクをプロジェクトに突っ込むというようにしている。

ただ、ここで問題なのは「プロジェクト」から具体化して「次にとるべきアクション」へ落とし込むべきだと思うんだけど、、、それが全然進んでいないこと。結局できないなら「いつかやる」に戻すべきなのかなー。

2010-11-13

▼ [雑][Mac] iMac 27" (mid 2010)が届いてた

昨日の午前中に届いていて、物理的な設置やらソフトウェアのインストールやらをやっている。画面でかいなーと思ってたけど、すでに慣れつつある。逆に今までのメイン機であった MacBook Pro の画面の狭さに驚愕したりして。

▼ [雑] MEDIA PASS で CD 収納スペースを減らす

古い CD は MP3 でリッピングしてあったりしたので、AAC でリッピングし直したいなと、だいぶ前から思っていた。で、iMac が届いたのをきっかけにその考えを実行することにした。

ついでにコクヨの「MEDIA PASS」 を使って CD の収納スペースを減らすことにしてみた。事前に評価は調べていたけど、思った以上にコレいいね。商品開発している人が「自分でこういうの欲しい!」と思って作っている(ホントのところは知らない)気がして、なんか好感が持てる。

今のところ50枚弱の CD を入れ替えてみたけど、収納スペースはかなり少なくなる。残りの CD は、200〜300枚くらいだと思うけど、かなり圧縮できそうで気持ちがいい。リッピングしながらなので時間はかかりそうだけど。

あと、「初回限定版」は、そのまま取っておきたい。この収納スペースは圧縮できないけど、、、ま、それはそれでヨシということにしておく。

2014-11-13

▼ [Elasticsearch] そういえば Elasticsearch のバックアップ・リストアってどうなんだっけ?

昨日の「Elasticsearch で Web のクローリングを行なう」ってのは、だいたい動いているようなので、課題であった kuromoji のインストールをしようかと思ったのだが、そうするとマッピングの変更になって、今までのデータを一回消さないといけないはず。

マッピングの追加だけなら消さずともできるとかって記述をどこかで見かけた気がするのだけど、ちょっと忘れてしまった。調べ直さないといけないな。

まぁ、でも、今回は一度データを消して、再度クローリングをするようにしようと思ったものの、一旦ストアしたデータのバックアップってどうやればいいんだっけ?という疑問に答えられない自分がいたので、こちらはこちらで別途調べてみることにした。

公式のマニュアルだと「snapshot and restore」が該当っぽい。バックアップとは言わずに、スナップショットという用語を使っているようなので、この日記でも以降はスナップショットと表記する。

スナップショットの手順としてはこうなるのかな。

- スナップショットの定義

- スナップショットの取得の実行

- スナップショットの状態確認

ちょっとやってみよう。

スナップショットの定義

定義するのは、スナップショット取得のタイプとその保存場所になるようだ。

デフォルトで用意されているタイプは、fs と url みたい。fs は共有ストレージのことで、保存と(リストア時の)読み込みができる。url は読み込みのみ。

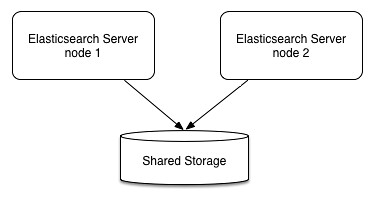

最初は、なんで「共有ストレージ」なの?と思ったけど、良く考えたら Elasticsearch は標準でクラスタ構築ができるので、そのデータは各サーバ(ノード)に分散保存されているのであった。

ノードが1台であれば、サーバ・ローカルのストレージに保存しても良いのだけど、複数サーバが絡んでくるなら、各サーバからアクセス可能な領域でないとダメだわなぁ。

つまり、こういうイメージになるわけだ。

と、まぁ、概念は理解したものの、いまはサーバ1台で動かしているので、ローカルのファイルシステムへ保存する設定にしておく。

snapshot.json

設定用のファイル。スナップショットを保存する先を仮に /tmp/es_backup とした。もちろん、本稼働する際には /tmp は使っちゃいけないんだけど、まぁ、実験だし。

ちなみにスナップショットのファイルは、Elasticsearch の稼働ユーザ権限でファイルが作られるので、パーミッションはそういう感じにしておく必要がある。

{

"type": "fs",

"settings": {

"location": "/tmp/es_backup",

"compress": true

}

}

設定の投入

_snapshot というエンドポイント(API)へ backup という名称で設定を PUT してやる。

% curl -XPUT 'http://localhost:9200/_snapshot/backup' -d @snapshot.json

{"acknowledged":true}

設定内容の確認

現在のスナップショット設定を確認するには、_snapshot API を GET してやればいい。この辺りは、ドキュメントの追加とかと同じ考えなので分かりやすいよな。

% curl -XGET 'http://localhost:9200/_snapshot?pretty'

{

"backup" : {

"type" : "fs",

"settings" : {

"compress" : "true",

"location" : "/tmp/es_backup"

}

}

}

設定内容の削除

ここまで来れば想像通りに DELETE で設定を削除できる。

% curl -XDELETE 'http://localhost:9200/_snapshot/backup'

{"acknowledged":true}

スナップショット取得の実行

実行するには、設定名 backup にスナップショットの名前を付けて PUT してやる。ここでは snapshot_1 という名前にしている。

$ curl -XPUT 'http://localhost:9200/_snapshot/backup/snapshot_1?wait_for_completion=true'

wait_for_completion ってのは、その名前の通りで、終了するまで待つってフラグらしい。テスト時には付けておいた方が分かりやすそうだけど、本番稼働時にはバックグラウンドで動作させるのが良いよね。

あ、でも、終了を待って次の処理をする場合とかにはフォアグラウンド動作の方が楽か。その辺は要件次第だなぁ。

スナップショットの状態確認

取得したスナップショットがどうなっているのか?は GET で取得できる。

% curl -XGET 'http://localhost:9200/_snapshot/backup/snapshot_1?pretty'

この取得方法だと、クラスタに含まれる全てのインデックスが含まれているようだ。

スナップショットの削除

スナップショットの削除は予想通り DELETE で実行する。

% curl -XDELETE 'http://localhost:9200/_snapshot/backup/snapshot_1'

{"acknowledged":true}

特定のインデックスを指定してスナップショットを取る

インデックス webindex のみのスナップショットを取ってみる。スナップショットの取得時に indices を指定することで、インデックスを指定することができるようだ。

{

"indices": "webindex"

}

これを snapshot_webindex.json というファイル名で保存し、そのファイルを指定する形でスナップショット取得を実行する。今度は wait_for_completion=true を付けずにバックグラウンドで実行してみる。

% curl -XPUT 'http://localhost:9200/_snapshot/backup/snapshot_2' -d @snapshot_webindex.json

{"accepted":true}

コマンド投入後、すぐに accepted が返ってきた。

しばらく待った後、状態を確認してみる。

% curl -XGET 'http://localhost:9200/_snapshot/backup/snapshot_2?pretty'

出力はこうなった。

indices の部分が先ほどと違って、webindex のみになっている。期待通りの動き。

この時、スナップショットの取得先として指定したディレクトリはこのようなファイル構成になっていた。

% ls -alF /tmp/es_backup/

total 24

drwxrwxrwx 3 suzuki suzuki 4096 Nov 13 21:49 ./

drwxrwxrwt 9 root root 4096 Nov 13 21:56 ../

-rw-r--r-- 1 elasticsearch elasticsearch 31 Nov 13 21:49 index

drwxr-xr-x 17 elasticsearch elasticsearch 4096 Nov 13 09:03 indices/

-rw-r--r-- 1 elasticsearch elasticsearch 176 Nov 13 21:49 metadata-snapshot_2

-rw-r--r-- 1 elasticsearch elasticsearch 178 Nov 13 21:49 snapshot-snapshot_2

indices ディレクトリの中を見てみる。

% ls -alF /tmp/es_backup/indices/

total 68

drwxr-xr-x 17 elasticsearch elasticsearch 4096 Nov 13 09:03 ./

drwxrwxrwx 3 suzuki suzuki 4096 Nov 13 21:49 ../

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 kibana-int/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.03/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.04/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.05/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.06/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.07/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.08/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.09/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.10/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.11/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.12/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 logstash-2014.11.13/

drwxr-xr-x 3 elasticsearch elasticsearch 4096 Nov 13 21:48 _river/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:48 robot/

drwxr-xr-x 7 elasticsearch elasticsearch 4096 Nov 13 21:49 webindex/

あれ?複数のインデックスが入っているように見える。おかしいな?と思ったので、各ディレクトリの容量を見てみる。

% du -sh /tmp/es_backup/indices/*

24K /tmp/es_backup/indices/kibana-int

24K /tmp/es_backup/indices/logstash-2014.11.03

24K /tmp/es_backup/indices/logstash-2014.11.04

24K /tmp/es_backup/indices/logstash-2014.11.05

24K /tmp/es_backup/indices/logstash-2014.11.06

24K /tmp/es_backup/indices/logstash-2014.11.07

24K /tmp/es_backup/indices/logstash-2014.11.08

24K /tmp/es_backup/indices/logstash-2014.11.09

24K /tmp/es_backup/indices/logstash-2014.11.10

24K /tmp/es_backup/indices/logstash-2014.11.11

24K /tmp/es_backup/indices/logstash-2014.11.12

24K /tmp/es_backup/indices/logstash-2014.11.13

8.0K /tmp/es_backup/indices/_river

24K /tmp/es_backup/indices/robot

3.0M /tmp/es_backup/indices/webindex

webindex のディレクトリだけがそれっぽい容量になっているので意図通りになっていそうだ。よしよし。

▽ おが [わかりましたよ、マイケル。などと日本語で喋るkittしか知らなかったので、英語のナイトライダーを見たときには、誰が喋..]

▽ ohsamu [売上3割は減るね,コングの「飛行機だけは勘弁だ」が聞けないAチームなんて…]

▽ Yu-Ki [吹き替えじゃないポワロと同じ位つまらないですね…]

▽ mu [http://www.alloha.info InsuRancE http://www.devonanal.com ..]